LLM架构介绍

从Llama 3到Kimi K2:一张图看懂现代大语言模型(LLM)架构的演进

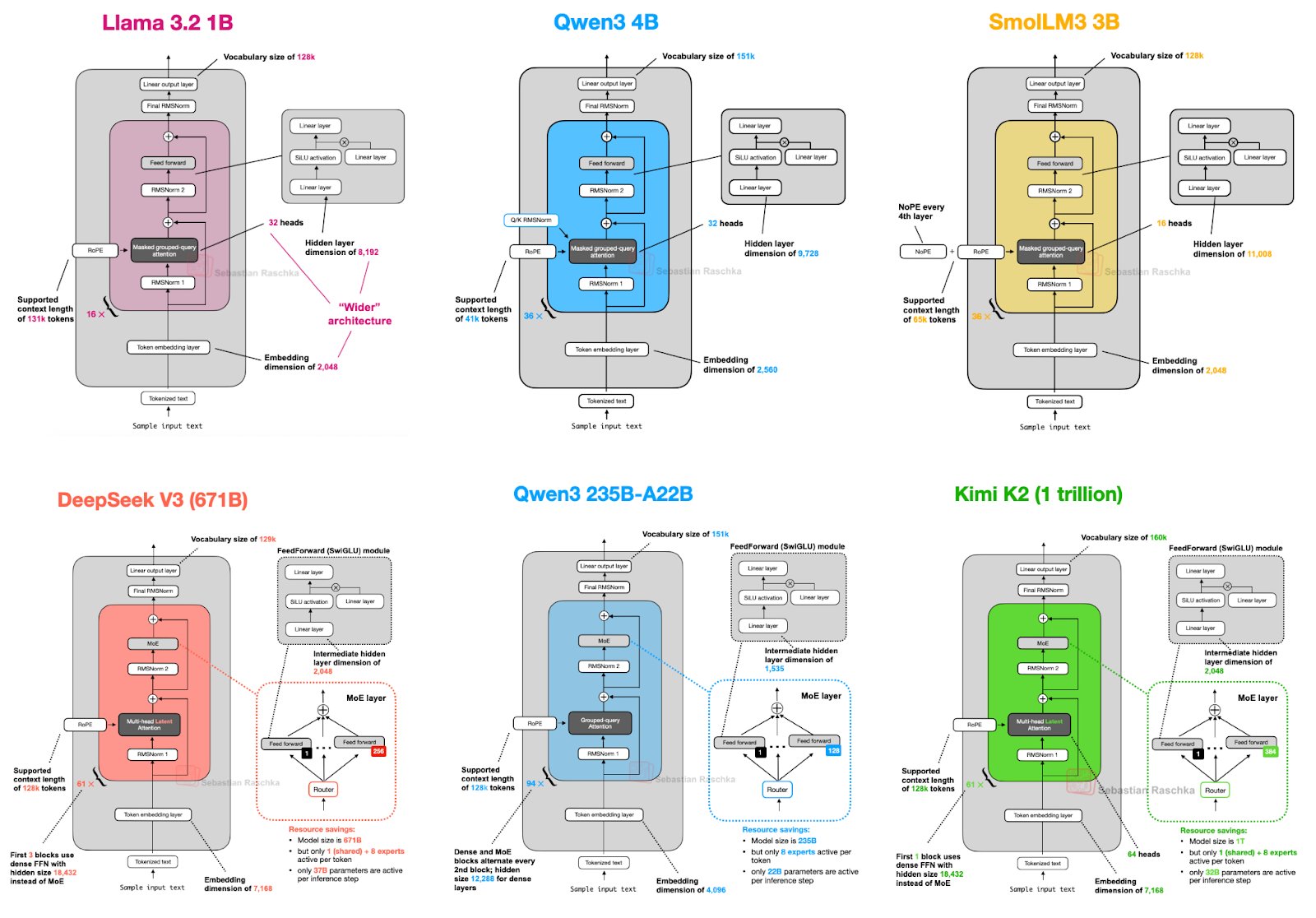

最近,一张清晰对比了六个主流大语言模型(LLM)架构的图片在技术圈广为流传。从几十亿参数的轻量级模型到万亿参数的庞然大物,这张图为我们提供了一个绝佳的窗口,来观察当今最前沿的LLM是如何设计和构建的。

对于许多对AI感兴趣的朋友来说,模型内部的“黑盒”总是显得神秘莫测。本文将以这张图为蓝本,为你逐一解析这些模型的架构特点,解释其中的关键技术概念,让你不仅能“看个热闹”,更能“看懂门道”。

核心技术概念解读:搭建你的知识框架

在深入探讨每个模型之前,我们先来了解一下图中反复出现的几个核心技术术语。理解了它们,你就掌握了解读LLM架构的钥匙。

- Vocabulary Size(词汇表大小): 这就像是模型的“字典”大小。它决定了模型能直接理解和生成多少种不同的单词或“token”(词元)。词汇表越大,模型处理多语言或特殊术语的能力通常就越强。

- Supported Context Length(支持的上下文长度): 这是模型一次性能“记住”和处理的文本长度,单位通常是token。比如,128k的上下文长度意味着模型可以阅读和分析一篇长达十几万字的小说,并在此基础上进行问答或创作,而不会“忘记”开头的内容。这是衡量模型长文本处理能力的关键指标。

- Embedding Dimension(嵌入维度): 在模型内部,文字无法直接计算,需要先转化成数字向量,这个过程就是“嵌入”。嵌入维度就是这个向量的长度。通常来说,维度越高,向量能携带的关于单词的语义信息就越丰富和细腻。

- Hidden Layer Dimension(隐藏层维度): 这是模型内部“思考”空间的宽度。在每一层网络中,输入数据会被转换到一个更高维度的空间进行处理。这个维度越大,通常意味着模型有更强的特征提取和表达能力,但也需要更多的计算资源。

- Attention Heads(注意力头): 这是构成LLM核心部件“注意力机制”的关键。如果说注意力机制是让模型聚焦于文本不同部分的方法,那么多头注意力(Multi-Head Attention)就是让模型能同时从多个不同的角度去关注文本。比如,一个头可能关注语法结构,另一个头可能关注语义关联。头的数量越多,模型分析文本的视角就越丰富。

- FeedForward (SwiGLU) & MoE:

- FeedForward Network (FFN):这是Transformer架构中的另一个核心组件,负责对注意力机制提取的信息进行非线性加工,增强模型的表达能力。

- SwiGLU:是FFN的一种高效变体。你可以把它理解成一个更智能的“门控”机制,它能更好地控制信息流,让模型训练起来更稳定,效果也更好。从图中可以看出,它已成为现代LLM的标配。

- Mixture of Experts (MoE / 混合专家模型):这是应对模型规模爆炸性增长的“聪明”策略。想象一下,一个问题你不需要请教公司里所有的专家,只需要找到最相关的几个就行。MoE就是这个原理。它将巨大的模型分割成多个“专家”子网络(Experts),每次处理数据时,只激活其中少数几个最相关的专家。这使得模型可以在总参数量巨大的情况下,保持相对较低的实际计算成本。

六大模型架构巡礼:从精巧到浩瀚

现在,让我们带着这些概念,开始我们的模型架构之旅。我们将模型分为两组:经典密集型模型和前沿的混合专家(MoE)模型。

第一组:经典密集型模型——坚实的基础

这类模型的特点是,在进行每一次计算时,模型的所有参数都会被激活。

Llama 3.2 1B & SmolLM3 3B:

- 共同点: 这两个可以看作是小规模模型的代表。它们都采用了相对传统的密集型架构,拥有标准的词汇表大小(128k)和中等偏下的上下文长度(8k-16k)。

- Llama 3.2 1B的“Wider”架构: Llama 3.2的特别之处在于其“更宽”的设计。相比于把网络做得“更深”,它选择了增加每一层的隐藏层维度(4,192),使其远超同等参数规模的模型。这种设计的理念是,更宽的网络可能在提取和处理特征方面更有效率。

- SmolLM3 3B的NoPE: 它明确标注了“NoPE”,即没有位置编码(Positional Encoding)。这通常意味着它采用了如RoPE(旋转位置编码)等更先进的方式来处理词元的位置信息,这已是现代LLM的主流做法。

Qwen3 4B:

- 超长上下文: 它的最大亮点是高达128k的支持上下文长度,这在几十亿参数规模的模型中是相当惊人的,展示了其在长文本处理上的野心。

- 均衡设计: 它的各项参数(嵌入维度、隐藏层维度)都相对均衡,没有像Llama 3.2那样进行特别的“加宽”,代表了一种更为经典的均衡设计思路。

第二组:混合专家(MoE)模型——通向万亿参数的智慧之路

随着模型参数突破千亿,MoE成为了“版本答案”。它的核心优势在于用更低的计算成本,换取巨大的模型容量和性能。

DeepSeek V3 (671B):

- 极致的MoE: DeepSeek V3是一个参数高达6710亿的庞大模型。它拥有160个专家,但每次只激活9个。这意味着实际参与计算的参数只占一小部分,极大地节省了推理成本。

- 共享专家: 它还引入了“共享专家”(Shared Expert)的概念,这部分专家是所有计算都会用到的,用于处理一些共性知识,而其他路由专家则处理更专业化的信息。

Qwen3 235B-A22B:

- “活性”参数: 模型名字中的“A22B”是关键信息,它代表了虽然总参数有2350亿,但实际激活(Active)的参数只有220亿。

- 高效路由: 它拥有64个专家,每次激活4个。这种设计在保证模型性能的同时,也实现了高效的计算路由,是MoE架构的典型应用。

Kimi K2 (1 trillion):

- 万亿“巨兽”: Kimi K2是目前参数规模的顶峰,达到了惊人的1万亿。它同样采用了MoE架构来管理如此庞大的参数。

- 精细化路由: 拥有128个专家,每次激活2个。这种“百里挑二”的精细化路由策略,可以在海量的知识库(专家)中,为特定任务精确地匹配到最合适的知识单元。这使得Kimi K2在保持强大能力的同时,推理成本依然可控。

核心技术概念流程示意图描述:

- Embedding(嵌入)流程:

- 单头注意力机制流程:

- 多头注意力机制流程:

- Mixture of Experts (MoE) 简化流程:

模型架构关键组件示意图描述:

Transformer Block 简化结构:

现在,让我们结合这些示意图的描述,更细致地理解关键知识点:

核心技术概念详解与示意图理解

Embedding(嵌入):

描述的流程图:

- 输入:

原始文本 (例如: "我 爱 你") - 箭头:

-> 通过嵌入层 -> - 输出:

数字向量 (例如: [0.2, -0.5, 0.8, ...], [0.1, 0.3, -0.9, ...], [0.7, -0.1, 0.4, ...])(每个词对应一个向量)

- 输入:

详解: 嵌入层的作用是将人类可读的词汇转换成机器能够理解和计算的稠密向量。这些向量在训练过程中学习得到,使得语义上相近的词在向量空间中的距离也更近。

单头注意力机制:

描述的流程图:

- 输入:

Query (Q), Key (K), Value (V)(都是输入文本的某种线性变换) - 步骤 1:

计算注意力权重: similarity(Q, K) -> 权重 (weights)(例如,通过点积然后进行Softmax归一化) - 步骤 2:

加权求和 Value: weights × V -> 注意力输出

- 输入:

详解: 注意力机制的核心思想是让模型在处理一个词时,能够“关注”到输入序列中与其他词的相关性。Query 代表“查询”,Key 代表“被查询的键”,Value 代表“被查询的值”。通过计算 Query 和 Key 的相似度,可以确定哪些 Key(以及对应的 Value)应该被更“重视”。

多头注意力机制:

描述的流程图:

- 输入:

Query (Q), Key (K), Value (V) - 并行处理 (多个“头”):

头 1: Q1, K1, V1 -> 注意力输出 1头 2: Q2, K2, V2 -> 注意力输出 2...头 N: QN, KN, VN -> 注意力输出 N

- 拼接:

Concatenate(注意力输出 1, 注意力输出 2, ..., 注意力输出 N) -> 拼接后的向量 - 线性变换:

拼接后的向量 × 权重矩阵 -> 多头注意力输出

- 输入:

详解: 多头注意力允许模型同时从不同的子空间学习到不同的注意力模式。每个“头”关注输入的不同方面,最终将这些不同的关注点结合起来,提供更丰富的上下文信息。

Mixture of Experts (MoE):

描述的流程图:

- 输入:

输入数据 - 路由网络 (Router Network):

输入数据 -> 计算每个专家的得分 -> 确定激活哪些专家 - 并行处理 (被选中的专家):

专家 1 (被选中): 输入数据 -> 专家 1 的输出专家 2 (被选中): 输入数据 -> 专家 2 的输出...

- 组合机制 (Combination Mechanism):

专家 1 的输出, 专家 2 的输出, ... -> 加权求和或更复杂的组合 -> MoE 输出

- 输入:

详解: MoE 的关键在于其稀疏性。并非所有参数都参与每一次计算,而是由一个路由机制决定哪些“专家”子网络应该处理当前的输入。这使得模型可以在拥有巨大参数量的同时,保持相对高效的计算。

Transformer Block 结构详解与示意图理解

**Transformer Block**:

* **描述的流程图**:

* **输入**: `上一层的输出或原始输入`

* **残差连接 1**: `输入 -> 分叉 -> 一路直接到加法器`

* **多头自注意力**: `另一路 -> 多头自注意力层 -> 输出`

* **加法 & 层归一化 1**: `残差连接 1 + 多头自注意力输出 -> 层归一化 -> 输出 1`

* **残差连接 2**: `输出 1 -> 分叉 -> 一路直接到加法器`

* **前馈神经网络**: `另一路 -> 前馈神经网络 -> 输出`

* **加法 & 层归一化 2**: `残差连接 2 + 前馈神经网络输出 -> 层归一化 -> 输出 2`

* **输出**: `输出 2 -> 下一层`

* **详解**:

Transformer Block 是构成现代LLM的基本 building block。

它由多头自注意力机制和前馈神经网络组成,

并引入了残差连接和层归一化来改善模型的训练过程。

* **自注意力**: 模型能够关注输入序列中不同位置的词之间的关系。

* **前馈神经网络**: 对每个位置的表示进行独立的非线性变换,增强模型的表达能力。

* **残差连接**: 有助于缓解深层网络训练中的梯度消失问题,使得信息可以直接跳过某些层。

* **层归一化**: 可以加速训练并提高模型的泛化能力。

总结与洞察:LLM架构的未来趋势

通过这张图,我们可以清晰地看到几个重要的行业趋势:

- MoE是通往更大模型的必由之路: 当模型参数跨越千亿门槛,MoE几乎成为唯一的选择。它完美地平衡了模型“容量”和“计算成本”之间的矛盾。

- 上下文长度持续内卷: 从最初的几千token到现在的128k甚至更长,LLM处理长文本的能力正在飞速发展,这将解锁更多应用场景,如长篇文档分析、全书内容问答等。

- 高效组件成为标配: 像SwiGLU这样的激活函数和RoPE这样的位置编码方法,因其优越的性能和稳定性,已经成为了现代LLM架构的“标准配置”。

- 架构设计的多样性: 即使在相似的规模下,模型设计者依然在探索不同的可能性,例如Llama 3.2的“加宽”策略。这种多样性推动着整个领域不断向前发展。